工作流(Workflows)是LangChat Pro的核心功能模块,通过可视化节点编排实现复杂的AI任务自动化处理。

工作流概述

工作流是LangChat Pro中的高级Agent应用类型,继承了标准Agent的所有基础功能,包括多渠道接入、对话日志记录和实时数据监控等核心能力。 工作流的核心价值在于通过可视化节点编排实现复杂的业务流程自动化,让用户无需编程即可构建智能化的AI应用。架构设计

工作流系统采用节点-连线的图论模型,将复杂的业务逻辑分解为可复用的功能节点,通过有向图的方式定义执行流程。数据结构模型

工作流的底层数据结构遵循标准的图论表示方法:工作流执行模型

设计约束与规范

拓扑约束

- 连通性要求:画布中的所有节点必须通过连线形成连通图,孤立节点将导致保存失败

- 有向无环图:工作流必须是有向无环图(DAG),禁止循环依赖

- 单一入口出口:每个工作流必须有且仅有一个开始节点和一个结束节点

执行约束

- 流程完整性:执行路径必须从开始节点流向结束节点,确保流程可正常终止

- 数据流转:节点间的数据传递必须通过连线明确声明

- 状态一致性:工作流状态变更必须通过保存操作持久化

建议在完成任何画布操作后,及时点击保存流程按钮,确保配置变更得到正确持久化。

全局配置管理

工作流编辑器的顶部操作栏提供了完整的流程管理功能,包括环境变量配置、实时测试、流程校验和应用发布等核心操作。环境变量配置

环境变量为工作流提供全局上下文,允许在整个流程执行过程中共享配置参数和业务数据。环境变量在流程启动时注入到执行上下文中,所有节点都可以通过变量引用语法访问这些全局数据。

- 点击操作栏的环境变量按钮

- 添加键值对形式的全局变量

- 支持字符串、数字、布尔值和JSON对象类型

使用示例:

使用示例:

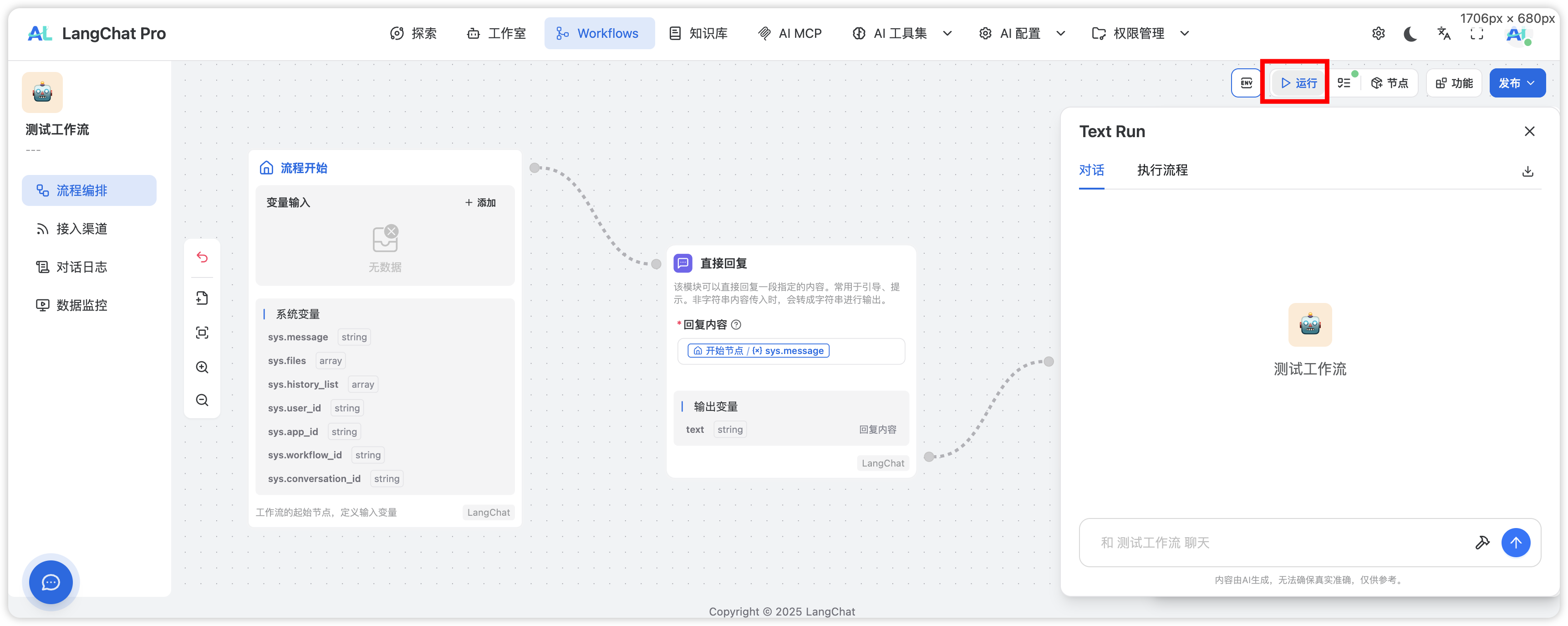

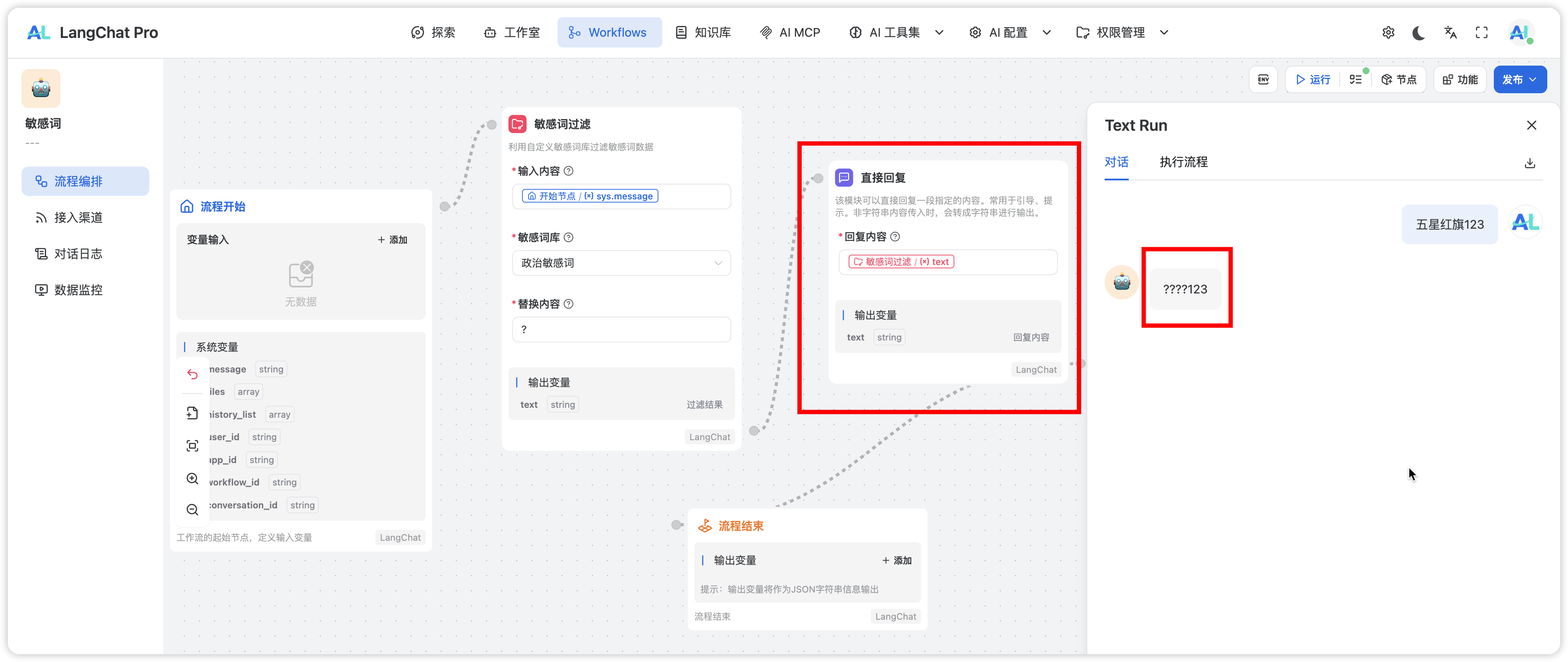

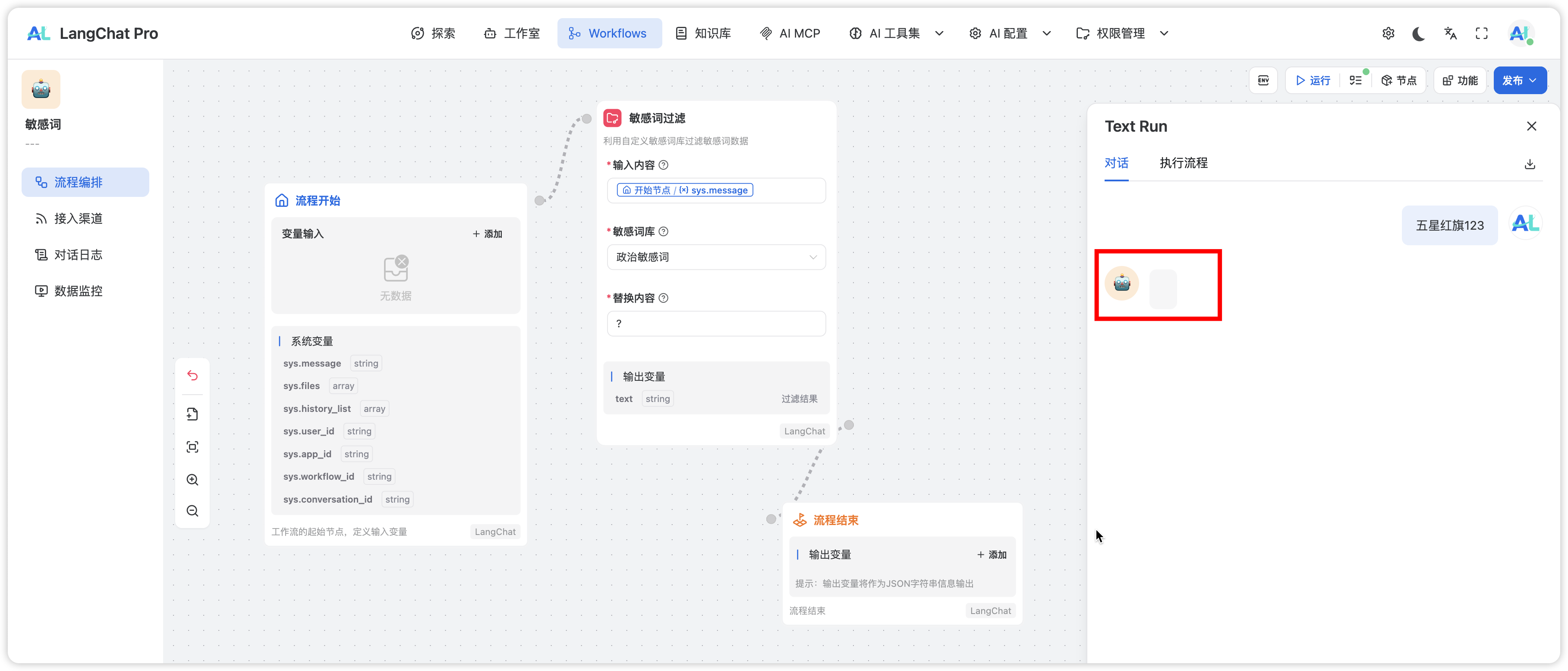

流程测试

内置的测试功能支持实时验证工作流逻辑,无需发布即可验证流程正确性。 测试特性:- 实时流式输出,模拟真实用户体验

- 独立的测试会话,不影响生产数据

- 支持断点调试和变量监控

流程校验

系统提供实时校验机制,自动检测工作流配置的合规性和完整性。 校验规则:- 拓扑结构验证(连通性、环检测)

- 节点配置完整性检查

- 数据类型匹配验证

- 业务逻辑合理性评估

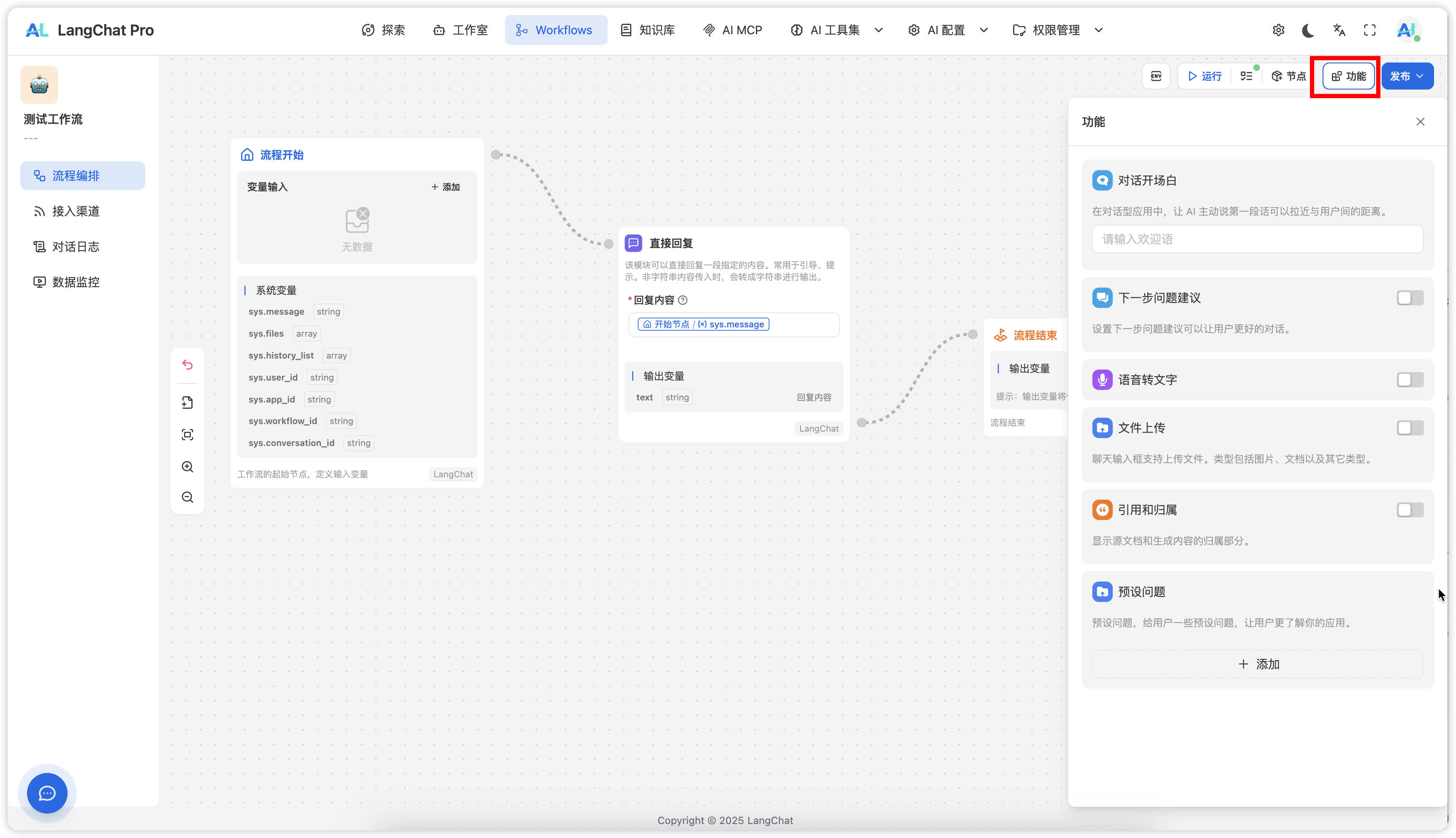

应用配置

工作流应用配置继承Agent的标准配置模式,提供统一的应用级参数管理。 配置项包括:- 基础信息(名称、描述、图标)

- 接入渠道配置

- 安全策略设置

- 性能参数调优

发布管理

支持版本化发布,确保工作流的稳定部署和回滚能力。 发布流程:- 保存草稿:保存当前编辑状态,不对外提供服务

- 发布上线:将工作流部署到生产环境,开始对外服务

- 版本管理:支持多版本并存和快速切换

画布

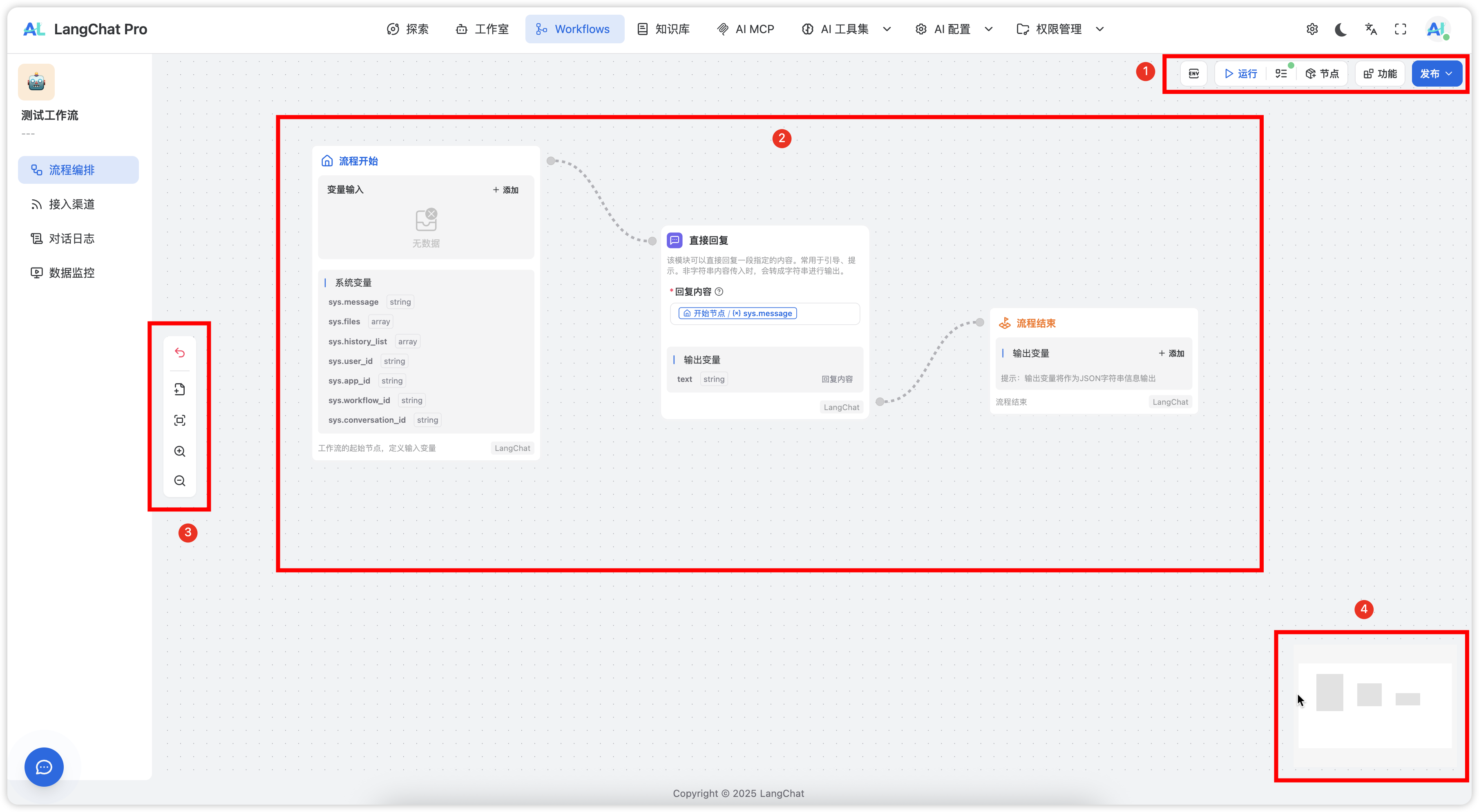

在LangChat Pro中,画布指的就是Workflows编辑的整个节点区域。 这里点击创建一个新工作流,点击进入你能看到如下:

- 操作栏,包含给此流程设置全局变量、运行测试、查看节点面板、查看功能面板、保存发布

- 节点区域,整个画布都是节点的拖拽区域

- 画布操作,可以放大缩小画布,添加备注节点

- 画布小窗口

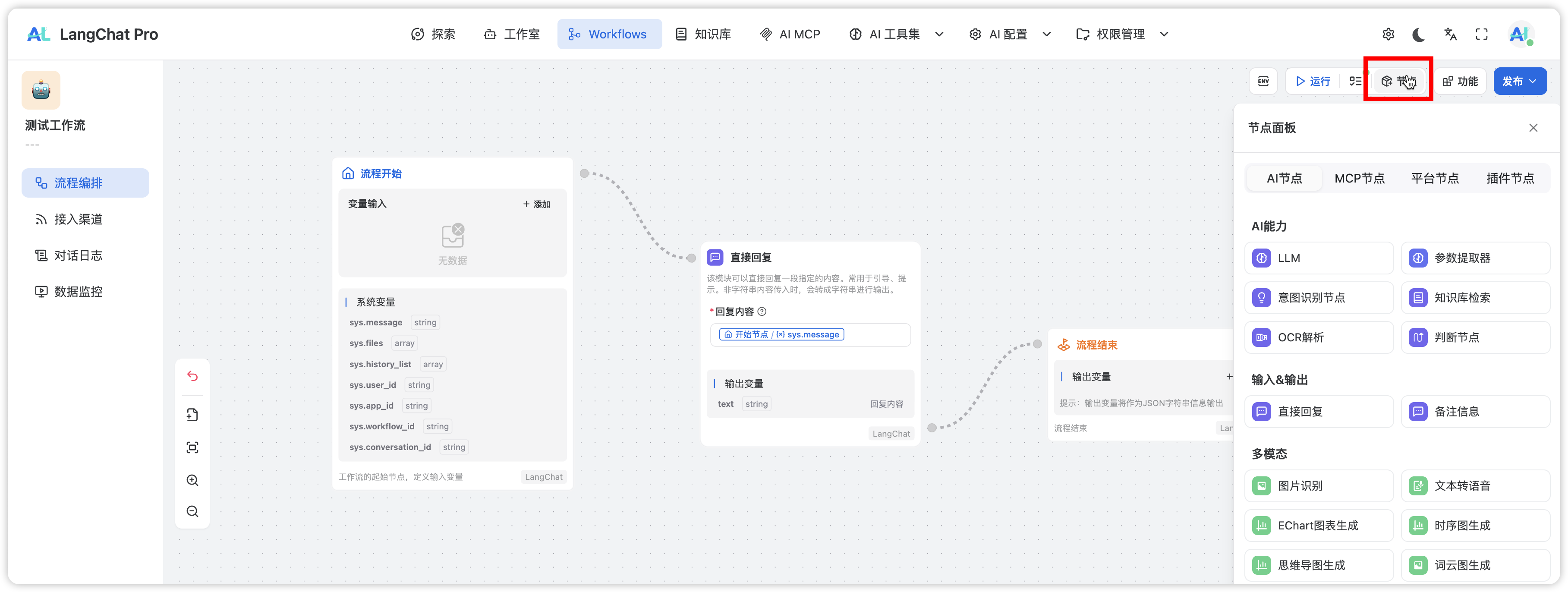

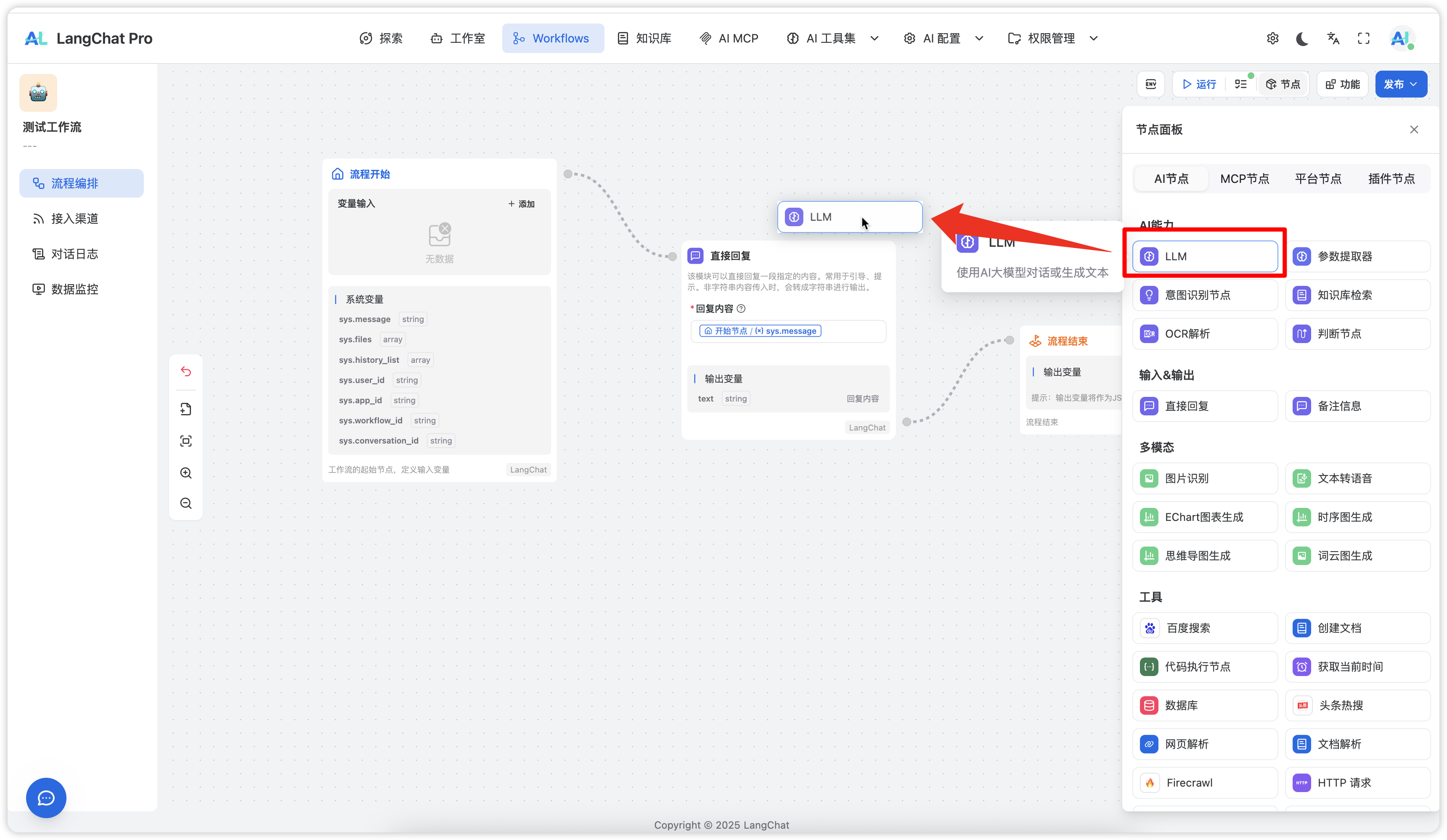

拖拽节点

如果你需要添加节点,需要点击画布右上角的 节点 按钮: 在弹出的节点面板中,可以鼠标长按点击任意节点然后往左拖拽到画布中:

在弹出的节点面板中,可以鼠标长按点击任意节点然后往左拖拽到画布中:

节点删除和复制

选中画布中的任意节点(除了开始结束节点),每个节点的右上角会显示操作按钮:

备注节点

LangChat Pro中提供了备注节点,可以拖拽任意数量的备注节点到任意位置,以便更清晰的展示节点: 如上所示点击左侧备注节点即可添加到画布中。

如上所示点击左侧备注节点即可添加到画布中。

节点类型体系

工作流节点采用分层架构设计,根据功能职责和执行特性分为三大类型:特殊节点

特殊节点是工作流的基础构件,负责流程的生命周期管理和文档说明。开始节点

- 功能:工作流的唯一入口点,初始化执行上下文

- 特性:系统保留节点,不可删除或复制

- 配置:支持设置初始输入参数和全局变量

结束节点

- 功能:工作流的终止点,清理执行资源

- 特性:系统保留节点,确保流程正常结束

- 配置:支持设置最终输出格式和清理逻辑

备注节点

- 功能:提供流程文档和说明信息

- 特性:不影响执行逻辑,仅用于增强可读性

- 配置:支持富文本编辑和自由定位

特殊节点是工作流的基础架构,开始和结束节点是必需的系统节点,备注节点可根据需要添加任意数量。

变量节点

变量节点负责数据处理和转换,是工作流的核心计算单元,不直接产生用户可见的输出。 核心特性:- 数据转换和计算处理

- 条件判断和分支控制

- 循环迭代和批量处理

- 变量传递和状态管理

- 敏感词过滤和内容清洗

- 数据格式转换和验证

- 业务逻辑计算和判断

- 外部API调用和数据获取

输出节点

输出节点是工作流的终端执行单元,负责将处理结果以不同形式输出给用户或外部系统。直接回复节点

直接回复节点将内部变量转换为用户可见的消息内容: 执行机制:- 接收上游节点的输出变量

- 将变量内容格式化为用户消息

- 通过SSE流推送到前端界面

- 敏感词过滤后的内容展示

- 数据处理结果的格式化输出

- 业务逻辑执行结果的反馈

LLM节点

LLM节点是智能输出节点,能够直接调用大语言模型并流式输出AI生成的内容: 核心特性:- 直接调用大语言模型API

- 支持流式输出和实时响应

- 无需额外的回复节点包装

- 内置提示词模板和参数配置

- 接收用户输入或上游节点数据

- 调用配置的LLM模型

- 实时流式输出生成内容

- 自动处理错误和重试机制

LLM节点集成了输出功能,无需额外配置回复节点,能够提供更加自然流畅的AI对话体验。