接入 Ollama 部署的本地模型

Ollama 是一款跨平台推理框架客户端(MacOS、Windows、Linux),专为无缝部署大型语言模型(LLM)(如 Llama 2、Mistral、Llava 等)而设计。通过一键式设置,Ollama 可以在本地运行 LLM,将所有交互数据保存在自己的机器上,从而提高数据的私密性和安全性。快速接入

下载并启动 Ollama

- 下载 Ollama 访问 Ollama 下载页,下载对应系统 Ollama 客户端。

-

运行 Ollama 并与 Llama3.2 聊天

启动成功后,ollama 在本地 11434 端口启动了一个 API 服务,可通过

http://localhost:11434访问。 如需运行其它模型,访问 Ollama Models 了解详情。 -

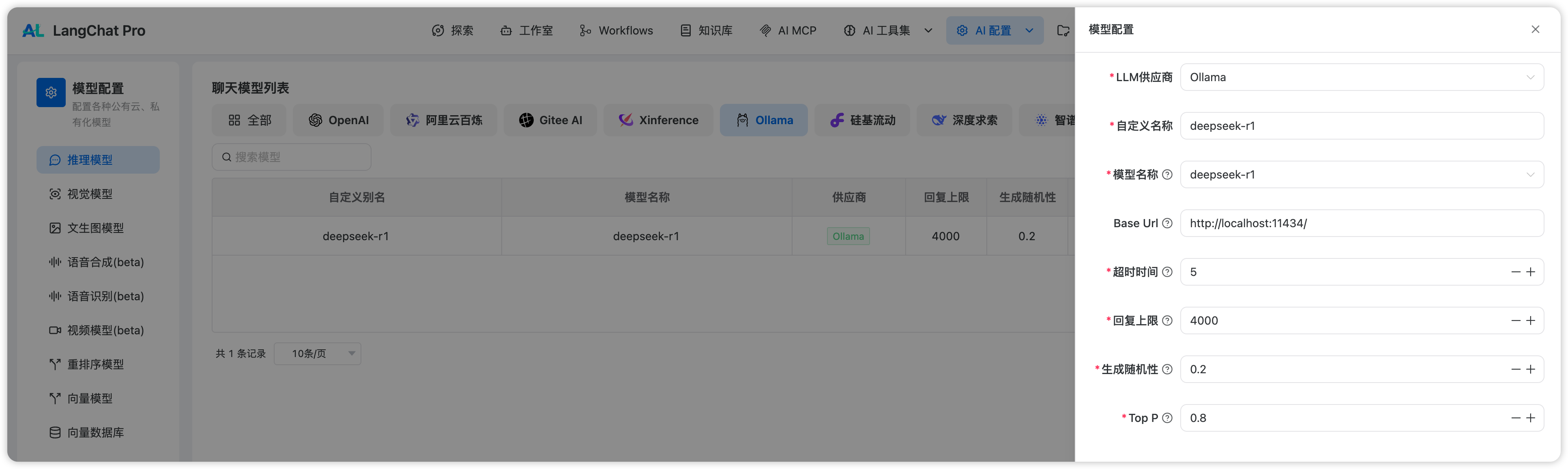

在 LangChat Pro 中接入 Ollama

在

设置 > 模型供应商 > Ollama中填入:

-

模型名称:

llama3.2 -

基础 URL:

http://<your-ollama-endpoint-domain>:11434此处需填写 Ollama 服务地址。如果填写公开 URL 后仍提示报错,请参考常见问题,修改环境变量并使得 Ollama 服务可被所有 IP 访问。 若 LangChat Pro 为 Docker 部署,建议填写局域网 IP 地址,例如:http://192.168.1.100:11434或 Docker 容器的内部 IP 地址,例如:http://host.docker.internal:11434。 若为本地源码部署,可填写http://localhost:11434。 -

模型类型:

对话 -

模型上下文长度:

4096模型的最大上下文长度,若不清楚可填写默认值 4096。 -

最大 token 上限:

4096模型返回内容的最大 token 数量,若模型无特别说明,则可与模型上下文长度保持一致。 -

是否支持 Vision:

是当模型支持图片理解(多模态)勾选此项,如llava。

-

模型名称:

FAQ

⚠️ 如果你使用 Docker 部署 LangChat Pro 和 Ollama,你可能会遇到以下错误:

在 Mac 上设置环境变量

如果Ollama 作为 macOS 应用程序运行,则应使用以下命令设置环境变量 launchctl:

-

通过调用

launchctl setenv设置环境变量: - 重启 Ollama 应用程序。

-

如果以上步骤无效,可以使用以下方法:

问题是在 docker 内部,你应该连接到

host.docker.internal,才能访问 docker 的主机,所以将localhost替换为host.docker.internal服务就可以生效了:

在 Linux 上设置环境变量

如果 Ollama 作为 systemd 服务运行,应该使用systemctl 设置环境变量:

-

通过调用

systemctl edit ollama.service编辑 systemd 服务。这将打开一个编辑器。 -

对于每个环境变量,在

[Service]部分下添加一行Environment: - 保存并退出。

-

重载

systemd并重启 Ollama:

在 Windows 上设置环境变量

在 Windows 上,Ollama 继承了你的用户和系统环境变量。- 首先通过任务栏点击 Ollama 退出程序

- 从控制面板编辑系统环境变量

-

为你的用户账户编辑或新建变量,比如

OLLAMA_HOST、OLLAMA_MODELS等。 - 点击 OK / 应用保存

-

在一个新的终端窗口运行

ollama

如何在我的网络上暴露 Ollama?

Ollama 默认绑定 127.0.0.1 端口 11434。通过OLLAMA_HOST 环境变量更改绑定地址。

如需获取 Ollama 更多信息,请参考